Ta część była dla mnie wyzwaniem – temat okazał się tak rozległy, że publikacja musiała zostać wstrzymana na dłuższy czas. Samych materiałów, bez zdjęć, grafik i tabel, zebrało się na ponad 40 stron tekstu! Byłem zmuszony skrócić niektóre kluczowe fragmenty historii, co oznacza, że nie wszystkie wątki otrzymały omówienie.

Po analizie materiału – uznałem, że trzecią część warto podzielić na dwa pod-rozdziały: część 3 poświęconą niematerialnym aspektom informatyki, takim jak algorytmy, programy, technologie i rozwiązania, oraz 3.5, gdzie skupię się na części sprzętowej.

Taki podział pozwoliłby bardziej szczegółowo przedstawić każdy z tych aspektów – tutaj pewne sprzętowe aspekty i tak będą.

Skróconą wersję, która i tak liczy kilkanaście stron, przedstawiam poniżej. Tym bardziej, że po zsumowaniu materiałów z pierwszej, drugiej i trzeciej części okazało się, że całość ma niemal 100 stron. Być może nadszedł czas, by przemyśleć wydanie tego w formie książki, która pozwoliłaby w pełni oddać bogactwo i złożoność tej historii. Zobaczymy, póki co:

Informatyka mechaniczna (jak to się zaczęło)

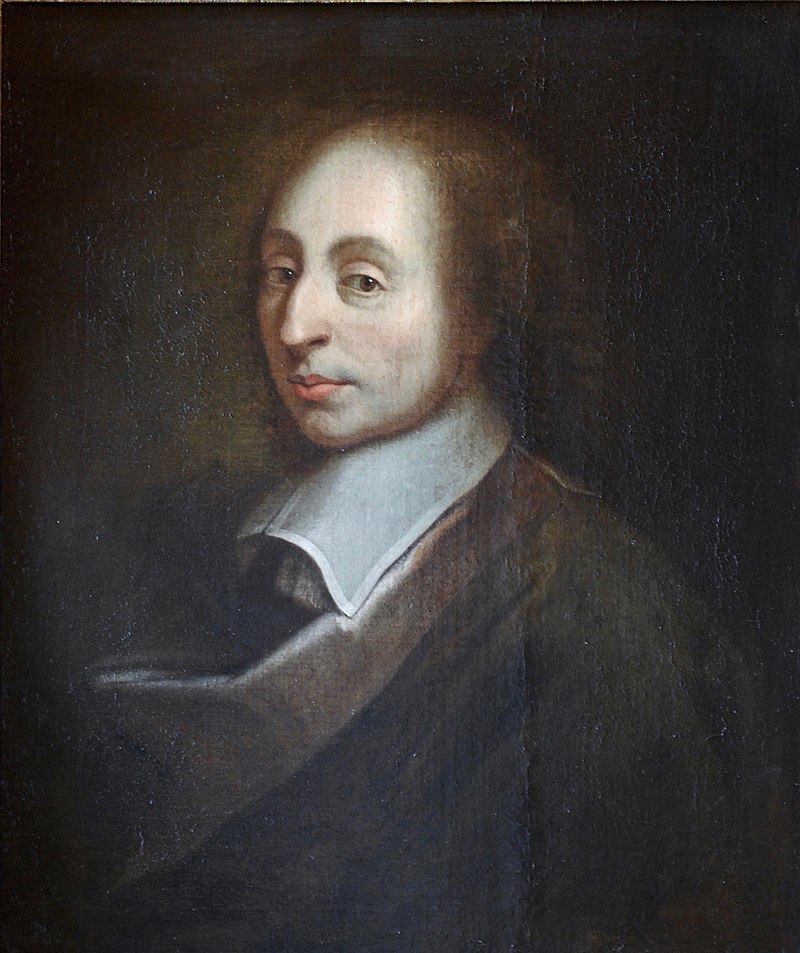

Wczesna informatyka mechaniczna wywodzi się z prostych narzędzi do liczenia, jak abakus czy liczydła, które przez stulecia były podstawowymi instrumentami obliczeniowymi. Jednak dopiero wraz z wynalazcami, takimi jak Blaise Pascal i Gottfried Wilhelm Leibniz, mechaniczne maszyny obliczeniowe zaczęły przybierać bardziej zaawansowaną formę.

Blaise Pascal – genialny francuski matematyk i fizyk, twórca pierwszej mechanicznej maszyny liczącej, zwanej Pascaliną. Stworzył ją w 1642 roku, by ułatwić obliczenia podatkowe swojemu ojcu. Jego wynalazek był kamieniem milowym na drodhttps://pl.wikipedia.org/wiki/Blaise_Pascalze do automatyzacji obliczeń.

Gottfried Wilhelm Leibniz – wybitny niemiecki filozof i matematyk, który nie tylko udoskonalił maszyny liczące, dodając do nich funkcje mnożenia i dzielenia, ale także zapoczątkował koncepcję arytmetyki binarnej – podstawę działania współczesnych komputerów.

Pascal, aby pomóc swojemu ojcu, poborcy podatkowemu, skonstruował w 1642 roku pierwszą maszynę liczącą, znaną jako Pascalina. Była ona w stanie wykonywać operacje dodawania i odejmowania. Urządzenie to, napędzane ręcznie za pomocą korby, bazowało na precyzyjnie skonstruowanych kołach zębatych, co przypominało technologię używaną w zegarach. W jego ślady poszedł Leibniz, który dodatkowo opracował maszynę zdolną do wykonywania operacji mnożenia i dzielenia – wyprzedzając swoją epokę, Leibniz zaproponował nawet ideę arytmetyki binarnej, która jest podstawą współczesnych komputerów.

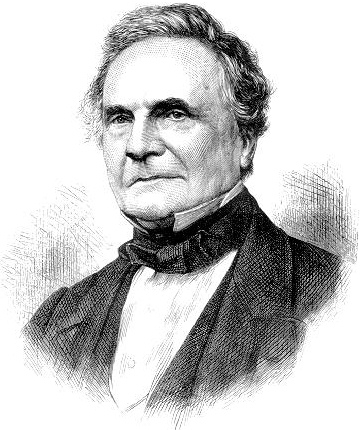

Jednak nie wszystkie eksperymenty były udane. Charles Babbage, często nazywany ojcem komputera, opracował w XIX wieku projekt tzw. maszyny różnicowej, przeznaczonej do rozwiązywania równań różnicowych. Choć jego wynalazek był niezwykle zaawansowany, problemy techniczne, brak funduszy i skomplikowanie samego projektu sprawiły, że maszyna nigdy nie została w pełni zrealizowana. Mimo to, prace Babbage’a i jego koncepcja maszyny analitycznej stanowiły fundament dla późniejszych komputerów.

Charles Babbage, często nazywany ojcem komputera, w XIX wieku zaprojektował maszynę różnicową, zdolną do rozwiązywania równań matematycznych. Jego koncepcja maszyny analitycznej stała się fundamentem dla współczesnych komputerów, choć nigdy nie została w pełni zrealizowana za jego życia.

W międzyczasie, wynalazcy jak Jaquet-Droz obrali zupełnie inny kierunek. Jego niezwykle skomplikowane lalki-automaty, zdolne do pisania, rysowania i grania na instrumentach muzycznych, nie miały bezpośredniego związku z informatyką, ale pokazywały, jak daleko mogła sięgnąć wyobraźnia mechaników XVIII wieku. Choć automaty te nie rozwiązywały problemów obliczeniowych, były dowodem na to, że mechanika potrafiła wykonywać precyzyjne zadania – choć w ograniczonym zakresie.

Pierre Jaquet-Droz i jego syn Henri-Louis Jaquet-Droz, XVIII-wieczni szwajcarscy zegarmistrzowie, stworzyli niezwykle skomplikowane automaty, takie jak lalki zdolne do pisania, rysowania czy grania na instrumentach. Ich dzieła, będące mistrzostwem precyzyjnej mechaniki, zainspirowały późniejsze innowacje w automatyzacji i technologii.

Tak między Bogiem a prawdą, to właśnie takie podejście setki lat później stworzyło gry komputerowe na urządzeniach nijak do tego nie stworzonych.

Ale tutaj pojawia się coś, co powinno zainteresować Was bardziej. Te urządzenia były często gigantyczne, precyzyjne, ale… też pełne ograniczeń. William Thomson, czyli Lord Kelvin, stworzył maszynę do liczenia pływów – gigantyczne, mechaniczne urządzenie, które miało przewidywać ruchy pływów morskich! Wyobraźcie sobie, że do obliczeń z dziedziny fizyki używano koła zębatego, dźwigni i cięgien. Dzisiejszy smartfon mógłby wykonać te same obliczenia w mgnieniu oka, ale to była magia mechaniki w XIX wieku.

Z każdą z tych maszyn można było poczuć, że mechanika ma w sobie coś magicznego – przetwarzała liczby tak, jak my dzisiaj na laptopie czy telefonie, ale z pomocą przekładni i dźwigni. Każdy wynalazek to krok w stronę tego, co znamy jako współczesne obliczenia – precyzyjne, szybkie i oparte na czymś, co wtedy wydawało się czystą abstrakcją.

Pierwsze algorytmy z prawdziwego zdarzenia

Algorytm, w najbardziej ogólnym sensie, to zestaw kroków lub instrukcji, które prowadzą do rozwiązania określonego problemu. W życiu codziennym możemy myśleć o nim jako o przepisie kulinarnym czy instrukcji montażu mebli – obie te rzeczy zawierają sekwencję działań, które, jeśli wykonane poprawnie, prowadzą do zamierzonego wyniku. W matematyce, algorytmy są szczególnie istotne, ponieważ stanowią rdzeń procesu obliczeń.

Rozwój matematyki, począwszy od czasów starożytnych, a zwłaszcza od średniowiecza, to w istocie historia tworzenia coraz bardziej złożonych algorytmów. Od prostych metod, takich jak algorytm Euklidesa do wyznaczania największego wspólnego dzielnika, po złożone techniki analizy numerycznej, algorytmy stały się narzędziem matematycznym do wyprowadzania dowodów, obliczania wartości funkcji, rozwiązywania równań i optymalizacji procesów.

W świecie mechanicznych maszyn obliczeniowych, choć imponujących, brakowało czegoś kluczowego – precyzyjnych instrukcji, które mogłyby być wykonywane w sposób powtarzalny. To właśnie tutaj na scenę wchodzi Ada Lovelace, która opracowała pierwszy prawdziwy algorytm.

Ada Lovelace, XIX-wieczna matematyczka i córka poety Lorda Byrona, jest uznawana za pierwszą programistkę w historii. W 1843 roku, analizując maszynę analityczną Charlesa Babbage’a, stworzyła algorytm do obliczania liczb Bernoulliego – pierwszy program komputerowy, który wykraczał poza proste obliczenia, ukazując potencjał maszyn do przetwarzania bardziej abstrakcyjnych danych.

Tak kochani, jednym z pierwszych prawdziwych informatyków była kobieta i to nie byle jaka (w sumie należy jej się osobny artykuł)

W 1843 roku, pracując nad opublikowanymi notatkami dotyczącymi maszyny analitycznej Charlesa Babbage’a, Lovelace stworzyła algorytmo-program do obliczania liczb Bernoulliego. Był to pierwszy algorytm, który mógł być zaprogramowany na maszynie obliczeniowej, co czyniło Lovelace pionierką programowania.

Jej wizjonerskie spojrzenie na maszynę analityczną wykraczało daleko poza mechaniczne liczenie. Lovelace dostrzegła potencjał maszyny do wykonywania nie tylko operacji arytmetycznych, ale także do przetwarzania bardziej abstrakcyjnych danych, takich jak teksty czy muzyka. To podejście do obliczeń z perspektywy algorytmicznej dało początek koncepcji współczesnego programowania komputerowego.

Chociaż maszyna Babbage’a nigdy nie powstała, wizje Ady Lovelace stworzyły fundamenty, które doprowadziły do późniejszego rozwoju języków programowania i algorytmów stosowanych w komputerach. Co więcej, jej praca miała wpływ na przyszłe pokolenia informatyków, którzy rozumieli, że aby maszyny mogły przetwarzać informacje, muszą być odpowiednio zaprogramowane za pomocą precyzyjnych algorytmów.

W miarę jak zbliżamy się do epoki elektromechanicznych maszyn, to właśnie ten przełom w myśleniu o algorytmach przygotował grunt pod rozwój współczesnej informatyki. Było jednak coś jeszcze, długo niezauważane, a dziś nieco zapomniane we współczesnym programowaniu – arytmetyka binarna opracowana przez Gottfrieda Wilhelma Leibniza w XVII wieku. To ona umożliwiła wprowadzenie operacji na dwóch cyfrach: 0 i 1, co stało się podstawą współczesnych systemów cyfrowych. Równie istotny był rozwój algebry Boole’a, która pozwoliła na opisanie działań logicznych za pomocą prostych równań, co miało ogromny wpływ na tworzenie współczesnych obwodów logicznych i systemów komputerowych.

Zalążki programowania

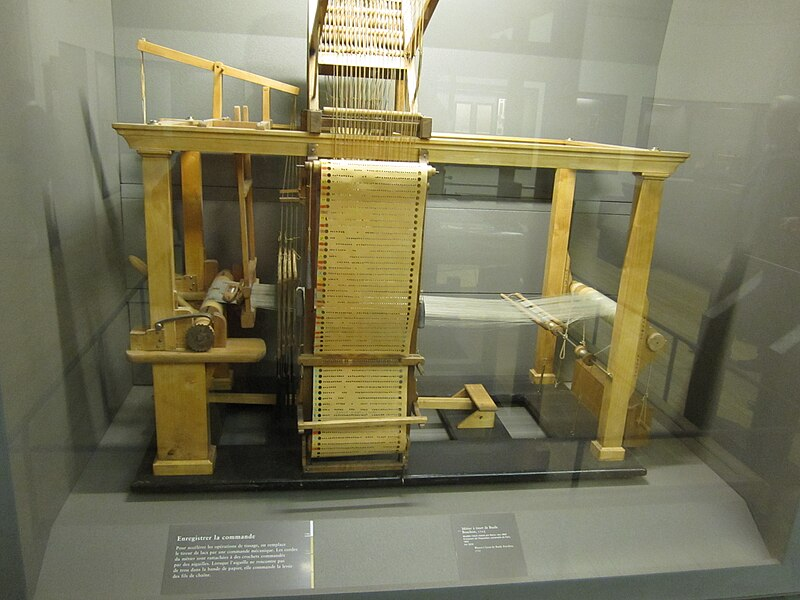

Gdy myślimy o programowaniu, nasze myśli zwykle wędrują w kierunku nowoczesnych komputerów i języków kodowania. Jednak historia programowania zaczyna się dużo wcześniej, w czasach, gdy nie istniały jeszcze komputery cyfrowe (takie jakie teraz znamy). Jednym z pierwszych przełomów była praca Basile’a Bouchona, który w 1725 roku stworzył krosno sterowane za pomocą papieru perforowanego. Wynalazek ten umożliwił maszynie „czytanie” prostych instrukcji, co zainspirowało późniejsze mechanizmy automatyzacji.

Joseph-Marie Jacquard rozwinął tę koncepcję, tworząc w 1801 roku słynną maszynę tkacką Jacquarda, wykorzystującą karty perforowane do programowania wzorów na tkaninach. Nieco później, w 1832 roku, Siemion Korsakow wykorzystał karty perforowane do automatyzacji wyszukiwania informacji w swoim systemie sensoryczno-perforacyjnym.

Pod koniec XIX wieku Herman Hollerith zastosował karty perforowane do przetwarzania danych podczas spisu ludności USA w 1890 roku, tworząc system, który znacznie przyspieszył obliczenia. Jego rozwiązanie stanowiło jeden z fundamentów współczesnej automatyzacji obliczeń.

Te wynalazki były kamieniami milowymi w historii programowania i stanowiły pierwsze próby zakodowania instrukcji w formie przetwarzalnej przez maszyny. Karty perforowane nie tylko zrewolucjonizowały przemysł tekstylny, ale także znalazły zastosowanie w obliczeniach i zarządzaniu danymi, stając się zalążkiem nowoczesnego programowania. Co ciekawe, już w 1832 roku Siemion Korsakow, w książce opublikowanej w Petersburgu, pisał o „wzmacniaczach naturalnej inteligencji”. To jedno z pierwszych historycznych odniesień do idei, które dziś znamy jako sztuczną inteligencję – myśl, która wtedy wyprzedzała swoje czasy.

Koncepcja języków programowania

Języki programowania to zestawy instrukcji umożliwiające tworzenie programów sterujących działaniem maszyn – najpierw mechanicznych, a później elektronicznych komputerów. Pierwsze tego rodzaju koncepcje sięgają XIX wieku, kiedy Ada Lovelace zaprojektowała algorytm do maszyny analitycznej Charlesa Babbage’a, uznawany za pierwszy program komputerowy. Pisałem o tym wcześniej.

Z biegiem lat języki ewoluowały od niskopoziomowych, bliskich maszynie, aż po wysoko abstrakcyjne, zrozumiałe dla człowieka i łatwe do adaptacji. Każda generacja języków programowania poszerzała możliwości komputerów, pozwalając na coraz bardziej skomplikowane zadania w nauce, biznesie, a także rozrywce.

W miarę rozwoju technologii wokół samego kodowania zaczęły powstawać szerokie ekosystemy narzędzi wspierających programistów. W latach 90. pojawiła się koncepcja RAD (Rapid Application Development) – podejście, które kładło nacisk na szybkie tworzenie aplikacji z wykorzystaniem wizualnych środowisk programistycznych i gotowych komponentów. Od teraz zamiast programować takie elementy jak okna, klawisze czy inne elementy interfejsu wystarczyła wizualnie (graficznie) przeciągać gotowe elementy i układać je na oknie (formie). Dodatkowo, jeżeli chcieliśmy mieć dostęp do zaawansowanych elementów jak bazy danych, wystarczyło przeciągnąć ikonkę a nie programować cały proces połączenia. RAD umożliwiało programistom budowanie interfejsów i logiki aplikacji poprzez przeciąganie elementów graficznych i łączenie ich z kodem, znacznie przyspieszając proces programowania. W tym okresie powstało także programowanie obiektowe (OOP), które pozwoliło na organizację kodu w formie obiektów – jednostek łączących dane i funkcje, co ułatwiało pisanie, utrzymanie i ponowne wykorzystanie kodu.

Współcześnie rozwój aplikacji wspiera się coraz bardziej na koncepcjach konteneryzacji i mikroserwisów, które zyskały popularność dzięki technologiom takim jak Docker czy Kubernetes. Kontenery umożliwiają uruchamianie aplikacji w odizolowanych, lekkich środowiskach, co zapewnia ich przenośność i stabilność między różnymi platformami. Mikroserwisy dzielą aplikację na mniejsze, niezależne komponenty, co ułatwia ich aktualizację i skalowanie. Te nowe podejścia w połączeniu z systemami zarządzania kodem, automatyzacją testów i integracji oraz chmurą obliczeniową pozwoliły stworzyć współczesne, złożone ekosystemy, które wspierają szybki rozwój i wdrażanie aplikacji.

Dziś istnieją setki języków programowania, ale na przestrzeni dekad kilka z nich wywarło szczególny wpływ na kształt nowoczesnej informatyki.

Kluczowe Języki Programowania

- Assembler (1947)

Język niskiego poziomu, używany do pisania kodu bliskiego maszynowemu. Umożliwia precyzyjną kontrolę nad sprzętem, ale jest trudny do nauki i modyfikacji. - Fortran (1957)

Stworzony z myślą o obliczeniach naukowych i inżynieryjnych. Do dziś używany w fizyce i astrofizyce. - LISP (1958)

Jeden z pierwszych języków programowania, popularny w sztucznej inteligencji. Jego struktura opiera się na listach i rekurencji. - COBOL (1959)

Zorientowany na biznes i finanse. Język stabilny, często używany w systemach bankowych i rządowych. - ALGOL (1958-1960)

Fundamentalny dla rozwoju strukturyzowanego programowania i algorytmów. Wpłynął na późniejsze języki, takie jak Pascal i C. - BASIC (1964)

Opracowany w celu uproszczenia programowania dla amatorów. Stał się popularny w edukacji i na komputerach osobistych. - C (1972)

Wszechstronny język średniego poziomu, używany zarówno do aplikacji, jak i systemów operacyjnych. Do dziś stanowi podstawę wielu języków, w tym C++ i Java. - Pascal (1970)

Język edukacyjny, zaprojektowany z myślą o nauce struktur danych i programowania strukturalnego. - C++ (1983)

Rozwinięcie C o programowanie obiektowe. Znajduje zastosowanie w grach, aplikacjach oraz systemach. - Java (1995)

„Napisz raz, uruchom wszędzie” – obiektowy język, popularny w aplikacjach webowych, mobilnych i systemach backendowych. - Python (1991)

Wszechstronny, prosty do nauki, ale potężny język wykorzystywany w sztucznej inteligencji, analizie danych i aplikacjach webowych. - JavaScript (1995)

Kluczowy język dla interaktywności stron internetowych. Działa po stronie przeglądarki, co czyni go niezbędnym w web-dewelopmencie. - Ruby (1995)

Język programowania obiektowego, skupiający się na łatwości pisania i czytelności kodu. Popularny w aplikacjach internetowych. - PHP (1995)

Język skryptowy stworzony do dynamicznych stron internetowych. Znany z platformy WordPress i wielu innych systemów CMS. - Go (2009)

Efektywny język zaprojektowany przez Google, używany w dużych systemach serwerowych, aplikacjach chmurowych i mikrousługach.

Myślicie, że to wszystko? Nawet nie liznęliśmy tematu tego i tak przydługiego artykułu. istnieje wiele przełomowych rozwiązań i technologii, które miały istotny wpływ na rozwój programowania, zarówno w przeszłości, jak i obecnie. Pokaże Wam „tylko” kilka z setek naprawdę niezwykłych pomysłów. A na deser zostawię coś co mnie wgniotło w fotel.

Programistyczne rozwiązania i technologie

1. Systemy Kontroli Wersji (VCS)

- Narzędzia takie jak Git, Subversion (SVN), oraz Mercurial umożliwiły programistom śledzenie i zarządzanie zmianami w kodzie, co jest kluczowe dla pracy zespołowej. Współczesne systemy kontroli wersji pozwalają na ścisłą współpracę, cofanie zmian i łatwe rozwiązywanie konfliktów, co przyspiesza rozwój i utrzymanie złożonych projektów.

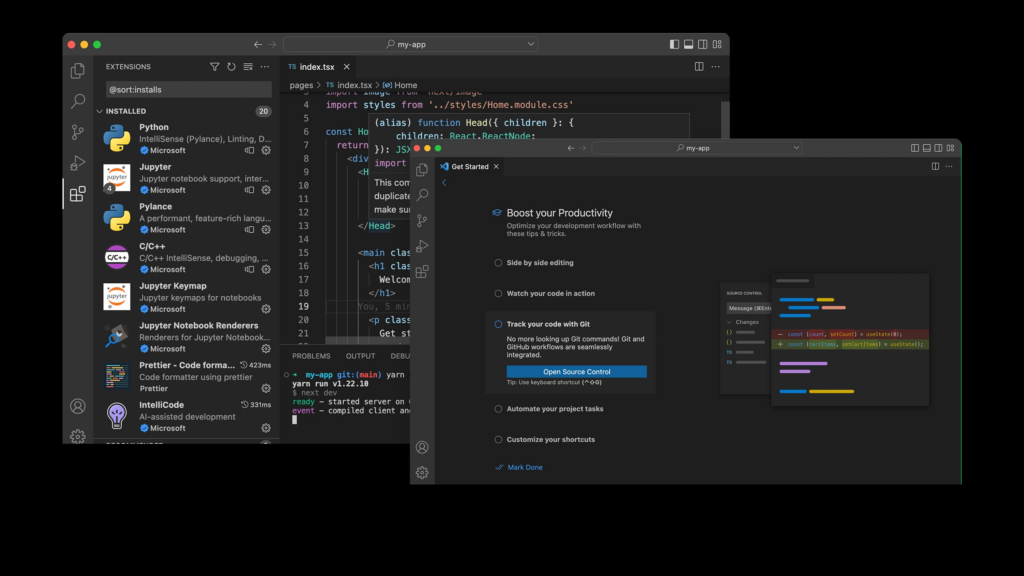

2. IDE – Zintegrowane Środowiska Programistyczne

- IDE (np. Visual Studio, IntelliJ IDEA, Eclipse) zrewolucjonizowały sposób pracy programistów, integrując edytor kodu, debugowanie, zarządzanie projektami i inne narzędzia w jednym miejscu. IDE umożliwiają szybkie pisanie i testowanie kodu, co jest szczególnie ważne w dużych, złożonych projektach.

- Frameworki (np. Django dla Pythona, Ruby on Rails dla Ruby, Spring dla Javy) dostarczają struktury aplikacji, co przyspiesza proces tworzenia, zmniejszając ilość powtarzalnego kodu. Użycie bibliotek, takich jak React dla interfejsów webowych czy TensorFlow dla sztucznej inteligencji, pozwala na korzystanie z gotowych, zoptymalizowanych rozwiązań.

4. Chmura Obliczeniowa i Serverless Computing

- Platformy chmurowe (AWS, Azure, Google Cloud) zmieniły sposób, w jaki rozwijane i wdrażane są aplikacje, oferując elastyczne zasoby obliczeniowe, przechowywanie danych i inne usługi „na żądanie”. Serverless computing, jak AWS Lambda, umożliwia tworzenie aplikacji bez zarządzania infrastrukturą, co przyspiesza rozwój i obniża koszty.

- Programowanie funkcyjne, bazujące na funkcjach matematycznych i pozbawione stanu, wraca do łask dzięki językom takim jak Haskell, Scala, oraz Elixir. Jego cechy, jak brak efektów ubocznych i łatwość równoległego przetwarzania, są szczególnie cenne w systemach rozproszonych i aplikacjach dużej skali.

6. CI/CD – Integracja i Wdrażanie Ciągłe

- Narzędzia i praktyki CI/CD (Continuous Integration/Continuous Deployment) pozwalają na automatyczne testowanie i wdrażanie nowych funkcji w aplikacjach. Platformy takie jak Jenkins, GitLab CI/CD, CircleCI czy GitHub Actions umożliwiają ciągłą integrację i automatyzację wdrożeń, co przyspiesza cykl rozwoju i zwiększa stabilność aplikacji.

7. Konteneryzacja i Orkiestracja

- Docker i Kubernetes umożliwiły konteneryzację aplikacji i zarządzanie kontenerami na dużą skalę. Konteneryzacja pozwala na odizolowanie aplikacji i łatwe ich uruchamianie w dowolnym środowisku, a Kubernetes automatyzuje zarządzanie, skalowanie i rozpraszanie kontenerów w chmurze, umożliwiając pracę w rozproszonym środowisku.

8. Event-Driven Architecture (Architektura Zdarzeniowa)

- W tej architekturze aplikacje reagują na zdarzenia (np. transakcje, działania użytkowników) zamiast sekwencyjnych działań. Popularna w systemach rozproszonych i aplikacjach czasu rzeczywistego, np. mikroserwisach, które wymagają szybkiej wymiany danych, używa się jej w połączeniu z technologiami jak Apache Kafka czy RabbitMQ.

- Bazy danych NoSQL (np. MongoDB, Cassandra) i rozwiązania do przetwarzania Big Data (np. Hadoop, Apache Spark) pozwoliły na efektywne zarządzanie ogromnymi wolumenami danych, które są trudne do przetworzenia w tradycyjnych bazach relacyjnych. Te technologie wspierają analizę danych na wielką skalę, co jest kluczowe w przemyśle, medycynie i finansach.

- Narzędzia do automatyzacji testów (np. Selenium dla aplikacji webowych, Appium dla aplikacji mobilnych) zmieniają sposób testowania oprogramowania, pozwalając na wykonywanie złożonych testów automatycznie. To skraca czas testowania i zmniejsza ryzyko błędów w produkcie końcowym.

11. API i Architektura REST/GraphQL

- API (Application Programming Interfaces) są kluczowe dla łączenia różnych aplikacji i usług. REST jest najczęściej stosowaną architekturą, natomiast GraphQL, rozwijany przez Facebooka, pozwala na bardziej elastyczne pobieranie danych. Oba podejścia odgrywają istotną rolę w integracji aplikacji i danych w środowiskach chmurowych.

- Edge computing przesuwa przetwarzanie danych bliżej źródła ich powstawania, co zmniejsza opóźnienia i obciążenie sieci. W połączeniu z Internetem Rzeczy (IoT), edge computing jest stosowany w autonomicznych pojazdach, inteligentnych miastach i przemysłowych systemach monitorujących, wspierając bardziej interaktywne i szybkie przetwarzanie danych.

Teraz deser

Microsoft Visual Studio Code – coś, co wgniotło mnie w fotel

Długo zwlekałem z poznaniem tego… ekhem… narzędzia (miałem nawet mieszane uczucia, czy to jest w ogóle jakieś rozsądne rozwiązanie, czy marketingowa wydmuszka – a mam kontakt z „tym czymś” od wersji 2015, wcześniej raczyłem się rozwiązaniami firmy Borland – teraz Embarcadero). Ale kiedy w końcu się do niego przekonałem i wgryzłem, mogłem dokonywać (i dalej mogę!) rzeczy niemal magicznych. W jednym „czymś” – bo nie wiem, czy nazwać to kombajnem, systemem deweloperskim, czy czymkolwiek innym – pisałem programy na moją ukochaną Amigę (i to na PC z systemem Windows!), na Arduino (czyli taki mikrokontroler), ale też aplikacje w C, C++, Pythonie, Javie, Delphi (Pascalu) i kilku innych językach, i to na różne platformy: od PC z Windowsem, po Linuxa, Androida (tak, to też Linux) czy nawet urządzenia z iOS!

A to dopiero początek. Można to wszystko połączyć z różnymi systemami AI, i kod… praktycznie pisze się sam (no, prawie). Możliwości, jakie daje to narzędzie, są tak niesamowite, że gdy je odkryłem, zbladłem, szczęka mi opadła i potłukłem płytki podłogowe, a w głowie rozpętało się tornado nowych pomysłów – chociaż niektórych rozwiązań „małego miekkiego” nie trawię to to akurat Microsoftowi wyszło. Ale na tym koniec słodkości – czas na twardsze, wojenne realia historii informatyki.

Informatyka idzie na wojnę

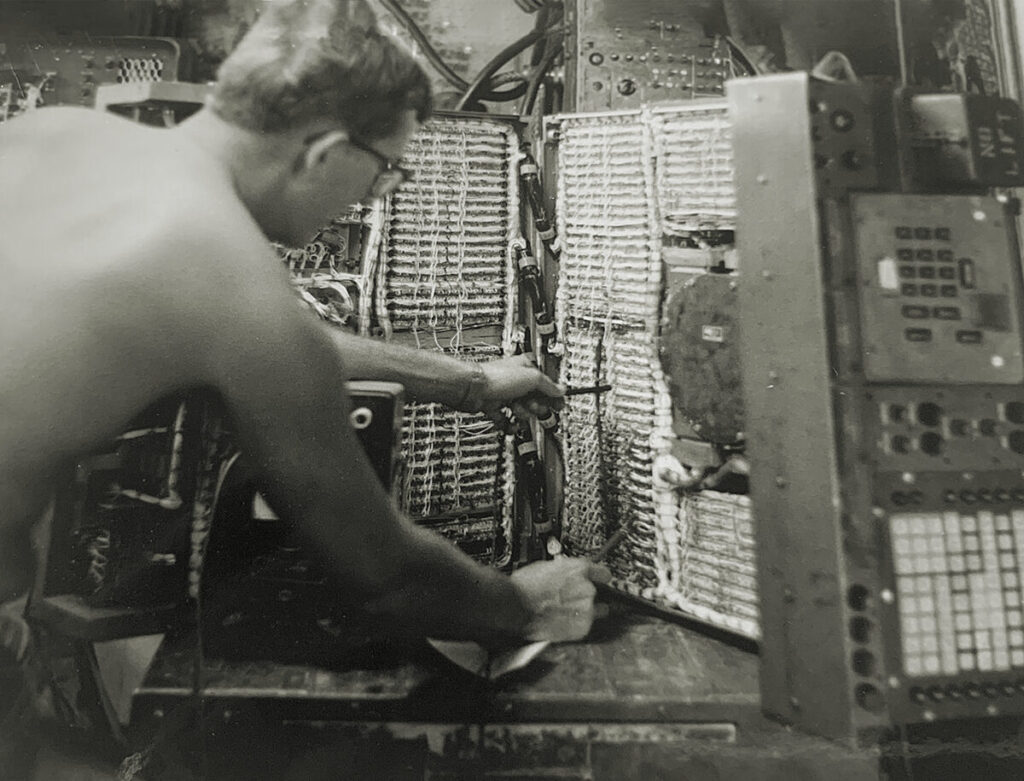

Każda generacja komputerów była kształtowana przez wydarzenia na świecie, a wojny znacznie przyspieszyły rozwój technologii (nie tylko tej). Już podczas I wojny światowej pojawiło się zapotrzebowanie na precyzyjne obliczenia balistyczne, co doprowadziło do rozwoju mechanicznych komputerów artyleryjskich. Te maszyny, używane na okrętach, obliczały trajektorie pocisków na podstawie parametrów takich jak prędkość wiatru, odległość do celu, kąt strzału i prędkość pocisku.

W trakcie II wojny światowej pojawiły się jeszcze bardziej zaawansowane technologie. Niemiecki Radar Würzburg, opracowany w firmie Telefunken, pozwalał na precyzyjne kierowanie ogniem artylerii przeciwlotniczej i reflektorów, co zwiększało skuteczność obrony. Amerykanie natomiast korzystali z Mark I Fire Control Computer i późniejszej wersji Mark IA, analogowych komputerów kontroli ognia, używanych na okrętach US Navy. Na niszczycielach montowano jeden taki system, a na pancernikach aż cztery, co pozwalało na dokładne obliczanie parametrów strzału w czasie rzeczywistym.

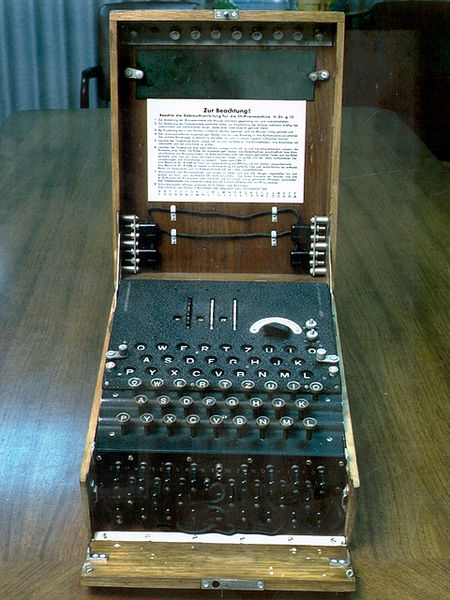

Poza technologiami artyleryjskimi, ogromną rolę odegrały maszyny szyfrujące i deszyfrujące. Niemiecka Enigma oraz amerykańska SIGABA były kluczowe dla bezpieczeństwa korespondencji wojskowej, a łamanie tych szyfrów miało ogromny wpływ na przebieg wojny. Nie były to komputery jednak wymusiły powstanie urządzeń około komputerowych. Alan Turing i jego zespół, przy wsparciu polskich matematyków – Mariana Rejewskiego, Jerzego Różyckiego i Henryka Zygalskiego – złamali szyfr Enigmy, umożliwiając aliantom dostęp do strategicznych informacji.

Mechaniczne maszyny obliczeniowe tamtej epoki były imponujące – ogromne, pełne trybików i dźwigni, precyzyjnie obliczały trajektorie pocisków czy analizowały dane szyfrowe. Choć dziś wydają się przestarzałe, ich rozwój był kamieniem milowym na drodze do nowoczesnych komputerów.

Po wojnie nadszedł czas na pierwsze komputery pierwszej generacji, jak ENIAC, które zrewolucjonizowały naukę i technologię. W latach 50. maszyny te, początkowo lampowe, były wykorzystywane w wojsku, a później znalazły zastosowanie w naukach ścisłych, szczególnie w fizyce atomowej i misjach kosmicznych. Kolejne generacje komputerów, napędzane potrzebami militarnymi i naukowymi, jak druga generacja oparta na tranzystorach czy trzecia oparta na układach scalonych, były kluczowe dla zimnowojennego wyścigu technologicznego i eksploracji kosmosu.

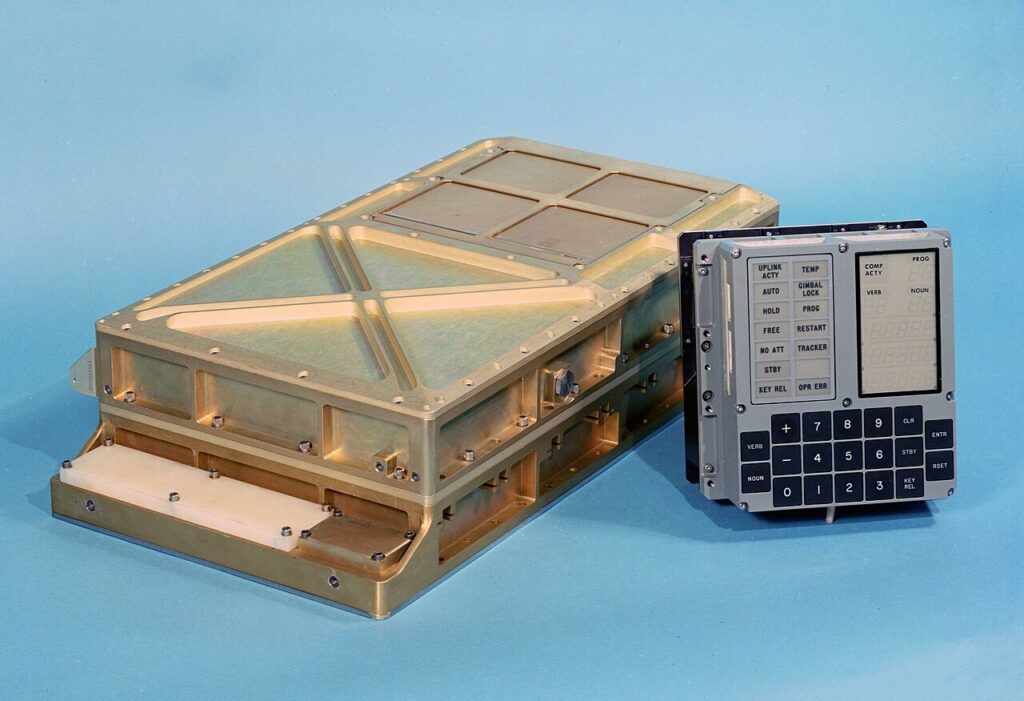

Kolejne generacja komputerów odzwierciedlały potrzeby i wyzwania swoich czasów. Druga generacja (lata 60.) z tranzystorami rozpoczęła zimnowojenny wyścig technologiczny między USA a ZSRR. Trzecia generacja, oparta na układach scalonych, wspierała eksplorację kosmosu – to właśnie te komputery były używane podczas misji Apollo, lądując człowieka na Księżycu.

To, co warto zrozumieć, to fakt, że potrzeby militarne, polityczne i naukowe były głównymi czynnikami napędzającymi rozwój komputerów. Zmieniający się świat, nowe konflikty i wyzwania – od wojen, przez zimną wojnę, aż po współczesne problemy, takie jak bezpieczeństwo cybernetyczne – stale wymuszały postęp technologiczny, a komputery stały się centralnym elementem tego rozwoju.

Wojny, zimna wojna, a nawet współczesne zagrożenia, takie jak cyberbezpieczeństwo, nieustannie napędzały postęp technologiczny, a komputery stały się jego nieodłącznym elementem.

Komputery – podróż od dziwactw do cudów technologii

Kiedy patrzymy na pierwsze komputery, niektórym mogą wydawać się raczej przestarzałe, wręcz dziwaczne i archaiczne. Jednak to właśnie one stanowiły fundament, na którym powstały dzisiejsze cuda technologii. Z biegiem lat naukowcy i inżynierowie wyznaczali kolejne kamienie milowe, które dziś klasyfikujemy jako „generacje” komputerów – choć trzeba przyznać, że nie jest to oficjalny spis. Oto moja (subiektywna) wizja tej podróży, rozpisana na generacje, a czasem i na pół-generacje, bo uważam, że każdy z tych etapów zasługuje na chwilę uwagi.

Generacja zerowa – Komputery mechaniczne i arytmomentry (XVII-XIX wiek)

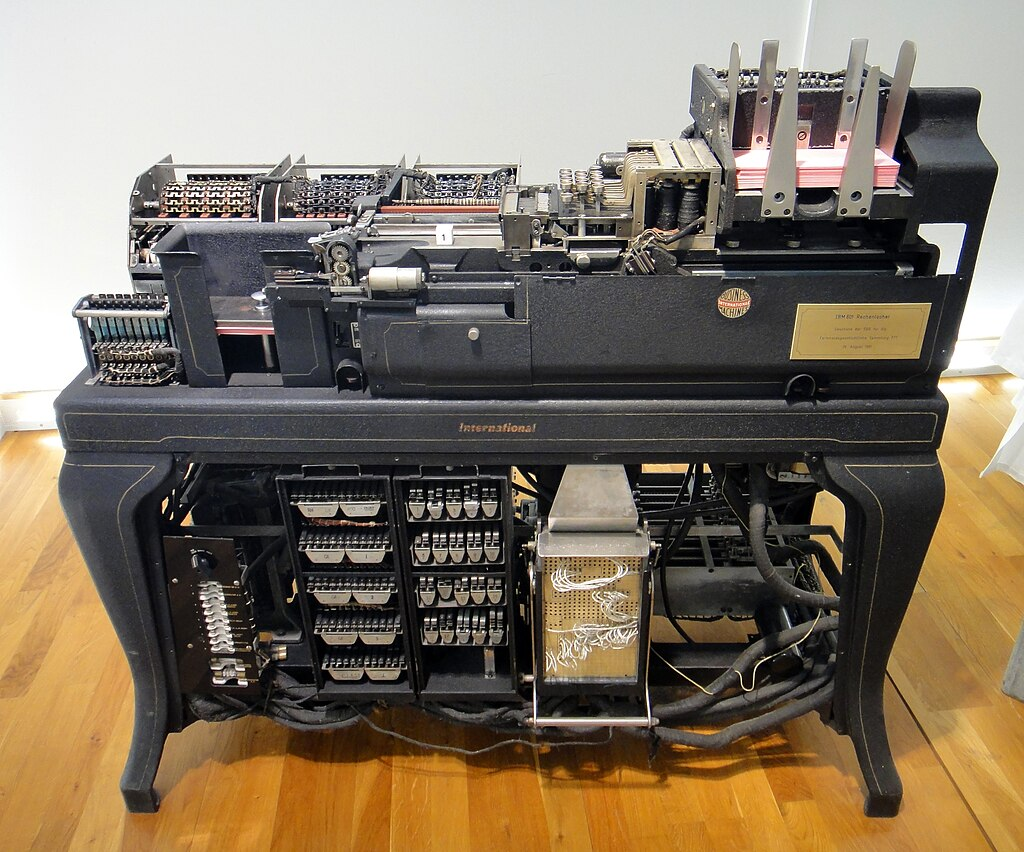

Generacja zerowa obejmuje mechaniczne maszyny obliczeniowe, które bazowały na kołach zębatych, dźwigniach i mechanizmach wychwytowych. Arytmometry, będące rozwinięciem idei Pascaliny Blaise’a Pascala oraz maszyn różnicowych Charlesa Babbage’a, były prostymi kalkulatorami mechanicznymi, które wykonywały dodawanie, odejmowanie, mnożenie i dzielenie. Arytmometry były powszechnie używane w biurach, fabrykach i instytucjach na całym świecie od XIX wieku aż do lat 70. i 80. XX wieku. Mimo swojej prostoty, stały się fundamentem dla późniejszych wynalazków, takich jak kalkulatory i komputery.

Generacja pierwsza – nieznośny stukot przekaźników.

Pierwsze komputery elektryczne bazowały na przekaźnikach, które wprowadzały automatyzację obliczeń. Konrad Zuse stworzył swój pierwszy komputer Z1 w 1935 roku – chociaż był to głównie mechaniczny komputer, wprowadził przekaźniki jako pierwsze elementy elektroniczne. Kolejny jego projekt, Z3 z 1941 roku, był pierwszym w pełni funkcjonalnym komputerem elektromechanicznym.

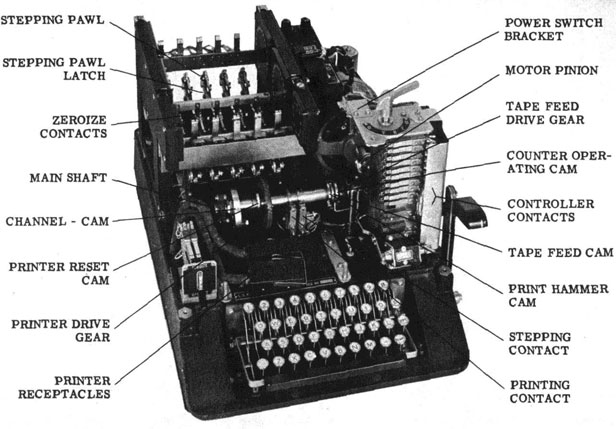

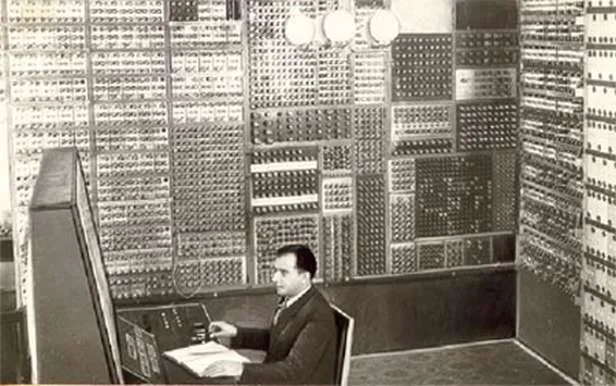

W USA, Harvard Mark I (1944), zaprojektowany przez Howarda Aikena we współpracy z IBM, również korzystał z przekaźników. Mark I był maszyną o długości prawie 16 metrów, używaną m.in. przez marynarkę wojenną USA do obliczeń balistycznych. Jego mechaniczne elementy były wspierane przekaźnikami, co umożliwiało bardziej zaawansowane operacje niż w poprzednich maszynach czysto mechanicznych.

Innym ważnym projektem był IBM Harvard Mark II oraz Bell Labs Model V, które usprawniały wykorzystanie przekaźników i były stosowane w badaniach naukowych i wojskowych. Mimo iż przekaźniki były wolniejsze i mniej niezawodne niż lampy próżniowe, to dzięki nim komputery tej generacji były w stanie wykonywać skomplikowane obliczenia na niespotykaną dotąd skalę.

Ciekawym urządzeniem tego okresu był również IBM 601, elektromechaniczny kalkulator z 1939 roku, który służył do prostych obliczeń, ale dzięki swoim funkcjom stał się inspiracją dla późniejszych, bardziej zaawansowanych systemów. W późniejszych generacjach, mimo rozwoju lamp próżniowych, przekaźniki wciąż były stosowane jako elementy pomocnicze, zanim zupełnie zdominowały je tranzystory.

Generacja druga – Lampy próżniowe (lata 40.-50. XX wieku)

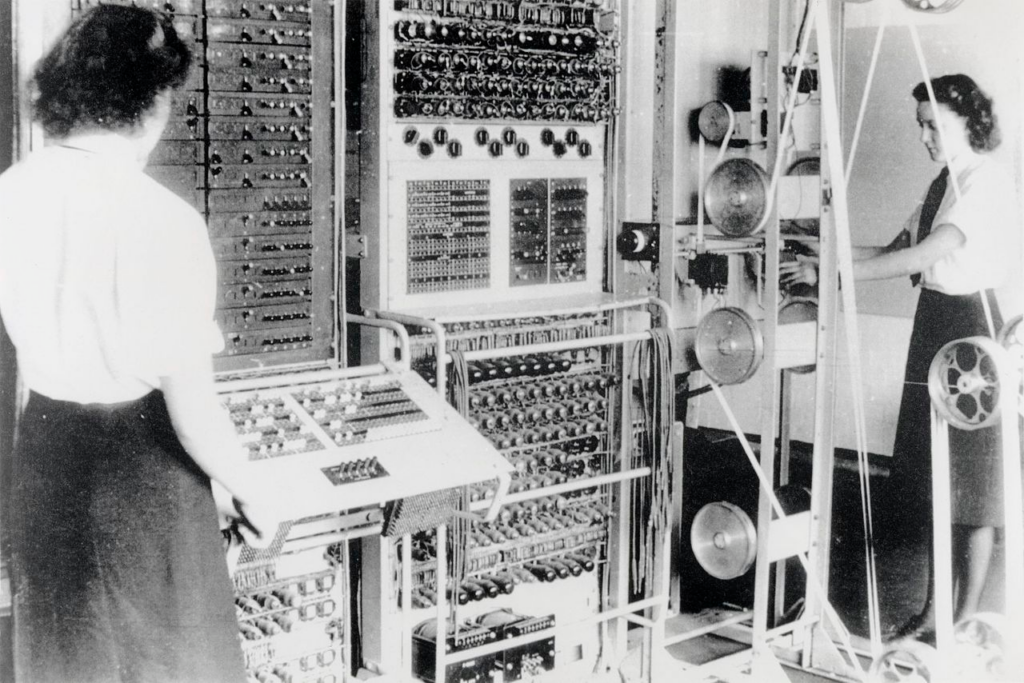

Wprowadzenie lamp próżniowych zrewolucjonizowało komputery, zwiększając ich moc i wszechstronność. Maszyny takie jak ENIAC i Colossus były pierwszymi, które korzystały z tysięcy lamp próżniowych do wykonywania złożonych obliczeń, szczególnie w czasie wojny. Dzięki lampom komputery były znacznie szybsze niż ich przekaźnikowe odpowiedniki, ale miały poważne wady – były ogromne, awaryjne, nagrzewały się i zużywały ogromne ilości energii.

Warto wspomnieć, że lampy nie wyeliminowały całkowicie przekaźników – wciąż były one stosowane w niektórych rozwiązaniach, co widać w komputerze Harvard Mark II. Komputery takie jak EDVAC i UNIVAC I rozwijały ideę lamp próżniowych, stając się fundamentem dla pierwszych komercyjnych zastosowań w przemyśle i administracji.

Ciekawą maszyną tego okresu był także komputer Whirlwind I (lata 50.), jeden z pierwszych komputerów czasu rzeczywistego, który oprócz lamp próżniowych wykorzystywał przekaźniki do dodatkowej kontroli systemu.

Generacja trzecia – Tranzystory (lata 50.-60. XX wieku)

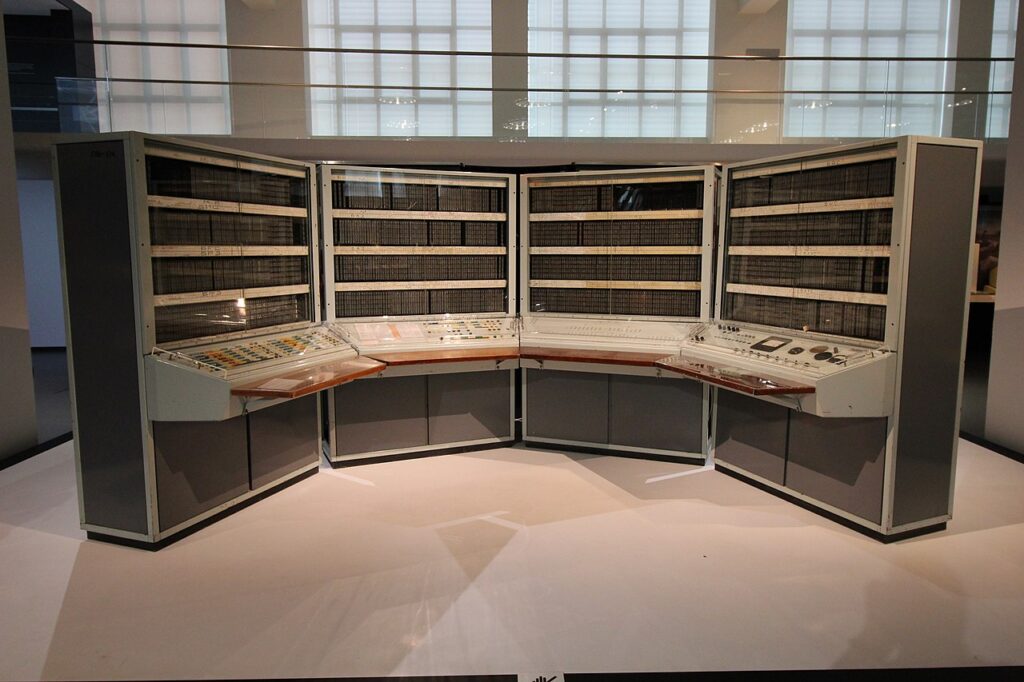

Zastąpienie lamp próżniowych tranzystorami było jednym z największych przełomów w historii komputerów. Tranzystory, wynalezione w 1947 roku przez Johna Bardeena, Waltera Brattaina i Willima Shockleya, przyniosły ogromną miniaturyzację, większą niezawodność i mniejsze zużycie energii. Komputery tej generacji, takie jak IBM 7090 i PDP-1, zaczęły pojawiać się w laboratoriach badawczych, firmach i uniwersytetach, co przyspieszyło rozwój przemysłu komputerowego.

Na zdjęciu: IBM 7151 konsola kontrolna dla 7090 to zaawansowana jednostka sterująca, używana do obsługi komputerów mainframe serii IBM 7090, wykorzystywanych w latach 60. XX wieku do intensywnych obliczeń naukowych i przemysłowych.

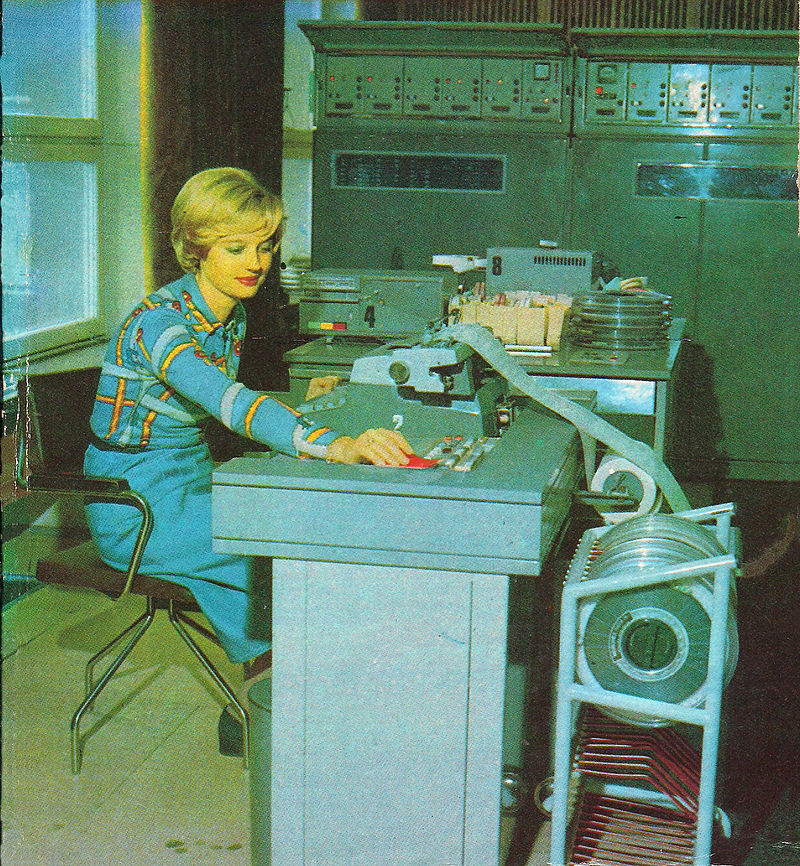

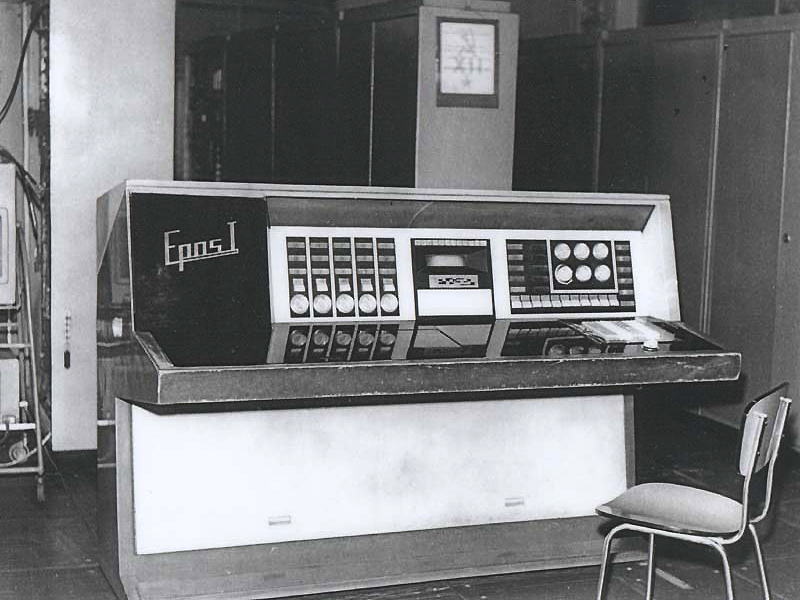

Jednak na całym świecie rozwijały się inne ciekawe projekty. W krajach bloku wschodniego powstały komputery takie jak BESM-6 (ZSRR), jeden z pierwszych tranzystorowych komputerów, który był szeroko wykorzystywany w nauce i przemyśle radzieckim. Odra 1003 i Odra 1013, stworzone w Polsce, były jednymi z najbardziej zaawansowanych maszyn tego okresu, używanych w przemyśle oraz administracji publicznej. W Czechosłowacji powstał EPOS 2, który również bazował na tranzystorach i był stosowany w przemyśle oraz badaniach naukowych.

https://en.wikipedia.org/wiki/BESM-6

Ależ mieliśmy piękne panie informatyczki 😉

W tym samym okresie w Japonii rozwijała się seria NEC 1100, która wprowadzała tranzystory do japońskiego przemysłu technologicznego, przygotowując grunt pod przyszły rozwój komputerów osobistych. W Stanach Zjednoczonych, oprócz komercyjnych komputerów jak IBM 1401, NASA korzystała z tranzystorowych komputerów podczas misji kosmicznych, m.in. Apollo.

Generacja tranzystorów to także czas rozwoju komputerów mini, takich jak DEC PDP-8, które były znacznie mniejsze od swoich poprzedników i bardziej dostępne. Rozpoczął się więc nowy etap w historii informatyki, gdzie komputery zaczęły być powszechniej stosowane w różnych branżach i instytucjach.

Generacja czwarta – Układy scalone (od lat 60. XX wieku)

Rozwój układów scalonych, który rozpoczął się w 1958 roku od wynalazku Jacka Kilby’ego, zmienił historię informatyki. Jego pierwszy układ scalony zawierał tranzystor, kondensator i oporniki, które emitowały prąd w formie sinusoidy. Początkowo układy scalone były proste – unipolarne (z jednym rodzajem nośników prądu) lub bipolarne (z dwoma rodzajami). Wkrótce zaczęto projektować bardziej złożone struktury, które integrowały więcej komponentów na jednym chipie.

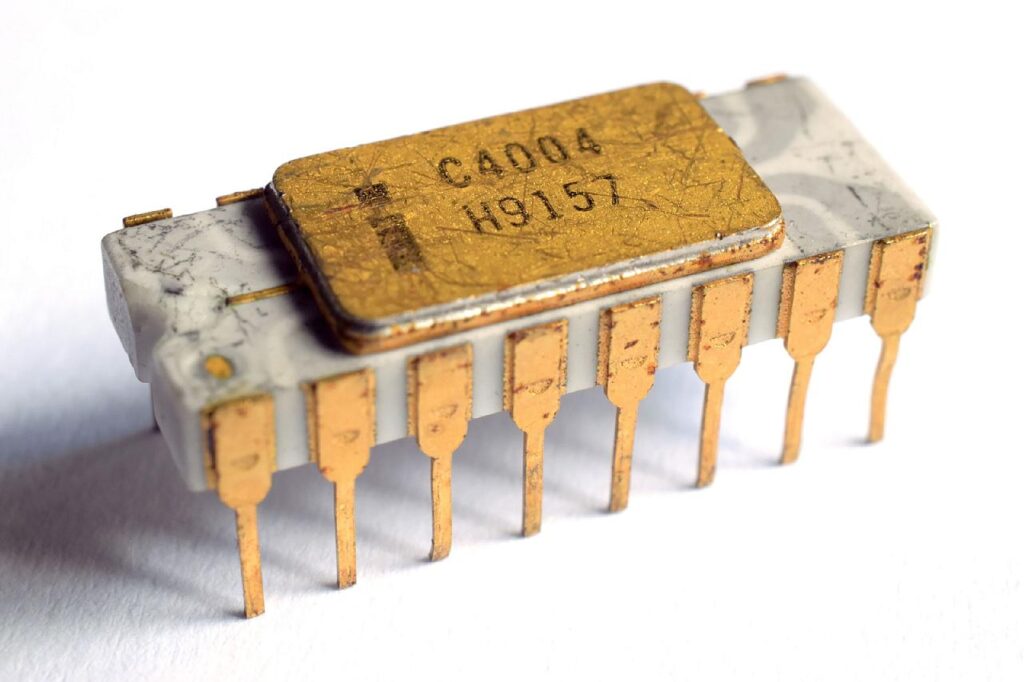

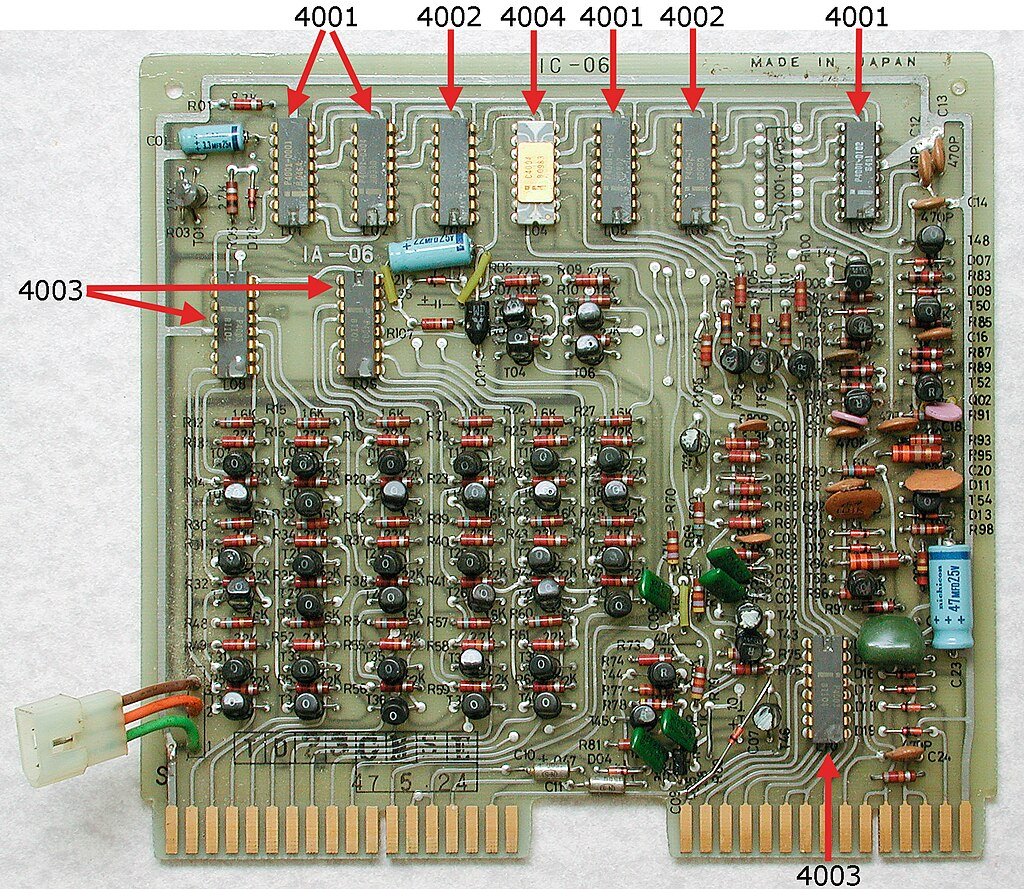

To właśnie w latach 70. mikroprocesor Intel 4004 zintegrował te osiągnięcia, oferując rewolucyjny 4-bitowy mikroprocesor, który dał początek komputerom osobistym. Procesory były czymś więcej niż „zlepkiem” elementów – umożliwiały pełną kontrolę nad obliczeniami to właśnie wtedy rozpoczęła się rewolucja. Układy scalone sprawiły, że komputery stały się mniejsze, bardziej dostępne i łatwiejsze w obsłudze.

Procesor, choć dziś uznajemy go za serce każdego komputera, był prawdziwą zagadką. Intel 4004 miał w sobie miniaturowy zestaw narzędzi: jednostkę arytmetyczno-logiczną (ALU), która odpowiadała za wszelkie obliczenia, rejestry magazynujące dane i akumulatory niczym maleńkie kieszonkowe pamiętniki. Do tego doszły jeszcze szyny danych przenoszące informacje, jak mikroskopijne drogi, oraz rejestr instrukcji – taki zarządca, który pilnował, aby każda komenda znalazła swoje miejsce. To wszystko, zamknięte w układzie wielkości paznokcia, było prawdziwą rewolucją, której twórcy sami nie do końca mogli uwierzyć.

Choć Intel 4004 jest uważany za pierwszy komercyjny procesor, wcześniejsze układy wojskowe, takie jak F14 CADC, pojawiły się w tajemnicy już w 1970 roku, choć ich istnienie zostało ujawnione dopiero lata później. Możliwe, że inne, bardziej złożone układy powstały wcześniej, ale tajemnica wojskowa mogła wymazać ich historię z kart oficjalnych dziejów.

W miarę upływu lat procesory zaczęły ewoluować, zaskakując coraz bardziej zaawansowanymi rozwiązaniami. Pojawiły się modele zdolne do równoczesnego przetwarzania wielu operacji – tak zwane jednostki wielordzeniowe, które miały niejako „wiele mózgów” w jednym układzie. Z czasem liczba tych wewnętrznych „mózgów” rosła, a układy zaczęły składać się z dziesiątków, setek, a nawet tysięcy małych procesorów współpracujących jak miniaturowa armia. Do gry wkroczyły też procesory programowalne, które można było dostosować do konkretnych zadań, oraz niezwykłe jednostki oparte na logice rozmytej, potrafiące działać bardziej intuicyjnie i przewidywać zmienne sytuacje, co było dużym krokiem naprzód w sztucznej inteligencji i sterowaniu.

Generacja piąta – „Obecnie panująca” to współczesne maszyny i urządzenia ale i Komputery kwantowe, biologiczne i fotoniczne

Komputery tej generacji to te „nasze” komputery, ale zanim do nich przejdę pokażę czym (według mnie) ta generacja się skończy, otóż granicą obecnej linii rozwojowej są urządzenia będące wytrychem do dalszego rozwoju. Komputery kwantowe, rozwijane przez Google, IBM czy D-Wave, wykorzystują kubity, co umożliwia równoległe przetwarzanie danych z niespotykaną wcześniej prędkością. Obecnie te maszyny są używane do symulacji molekularnych czy optymalizacji problemów. Komputery te rozwijają się dynamicznie, choć są jeszcze we wczesnej fazie rozwoju i wymagają stabilnych warunków pracy (temperatury bliskiej zeru absolutnemu).

Komputery fotoniczne, które zamiast elektronów korzystają z fotonów (cząsteczek światła), mają potencjał w przełamywaniu barier prędkości obliczeń. Dają ogromną przepustowość przy jednoczesnym niskim zużyciu energii. Polska, m.in. Politechnika Wrocławska i Uniwersytet Warszawski, prowadzi pionierskie badania nad fotoniką. Te technologie rozwijają się niezależnie od komputerów kwantowych i znajdują zastosowanie m.in. w szyfrowaniu danych oraz transmisji informacji optycznej.

„Mięskiem” tej generacji nie są tylko komputery oparte na zupełnie nowych zasadach fizyki. W tym czasie rozwinięto całe rodziny procesorów a także procesory wielordzeniowe i wielowątkowe, które umożliwiają równoczesne przetwarzanie wielu zadań (multitasking) i podział obliczeń na wiele mniejszych operacji (multithreading). Logika rozmyta znalazła swoje zastosowanie w procesorach, szczególnie w algorytmach sztucznej inteligencji. Wewnątrz nowoczesnych procesorów pojawiły się nawet wewnętrzne systemy informatyczne, które optymalizują pracę procesora w czasie rzeczywistym, samodzielnie rozdzielając zasoby i zarządzając operacjami. Całe rodziny procesorów zaczęły rozpychać się na rynku rywalizując ze sobą, współpracując a także tworząc nowe wcześniej nieznane nisze, które zostały zdominowane przez jedne procesory by inne nijak nie mogły się do tych dziecin dostać

Kolejną gałęzią są komputery biologiczne, które wykorzystują DNA do przechowywania i przetwarzania danych. Te technologie, choć w fazie eksperymentalnej, mogą mieć ogromny wpływ na przyszłość przechowywania danych. Zdolność DNA do magazynowania ogromnych ilości informacji w małych strukturach wyprzedza możliwości współczesnych nośników. Zastosowanie enzymów i innych stricte biologicznych technik do obliczeń czy zarządzaniem danymi zawartymi w DNA może by początkiem czegoś całkowicie odmiennego.

Istotną częścią informatyki był nie tylko sprzęt, ale (ponownie) algorytmy i oprogramowanie.

Wszystko ewoluowało, powstały technologie przechowywania i analizowania dużych danych, stworzono niesamowite sposoby zapisu danych, od pamięci ferrytowych, przez zapis magnetyczny, po zapis optyczny. Trwają prace nad zapisem danych w kryształach, kostkach żelu a nawet w DNA.

Pisanie programów przestało być żmudnym wklepywaniem kolejnych komend przenoszących słowa z jednej komórki pamięci do drugiej. Nastała era języków programowania, gdzie jedna komenda wykonywała czynność w skład której wchodziło tysiące komend mikroprocesora.

Powstały języki programowania wysokiego poziomu. Dodatkowo powstały technologie informatyczne wręcz wykluczające – do pewnego stopnia – programowanie. „Programista od teraz może przeciągnąć po ekranie element graficzny „łącz z bazą danych” by gdzieś w tle utworzył się cały kod nawiązujący połączenie z bazą danych.

W niektórych kręgach programowanie stało się sztuką! Powstała „scena” czyli takie zgromadzenie ludzi, gdzie prześcigano się w konkursach „kto napisze kod robiący „coś” lepiej niż inni.

Przechodzimy teraz do tej „dziwnej” części informatyki, jaką jest rozrywka. Pierwsze kroki w tej dziedzinie były zaskakująco skromne i przypadkowe. Kiedyś ktoś zauważył, że komputer podczas intensywnych obliczeń wydaje piski – coś na kształt dźwięków, które zmieniały się wraz z obciążeniem. Wystarczyło odpowiednio zaplanować obliczenia, aby te „piski” brzmiały w różnych odstępach czasu, a nawet tworzyły coś na kształt melodyjnych fraz.

Prawdziwy przełom w „muzycznej” informatyce nadszedł w 1961 roku, gdy komputer IBM 7094 został zaprogramowany, by wygenerować dźwięki przypominające muzykę i zsyntezować ludzki głos. To właśnie wtedy IBM 7094 „zaśpiewał” słynną piosenkę Daisy Bell („Daisy, Daisy, give me your answer do…”), otwierając nowy rozdział w historii komputerów – rozrywkę muzyczną. Niespodziewanie komputery zaczęły nie tylko liczyć, ale też 'śpiewać’, co nie tylko zadziwiło, ale i zainspirowało kolejne pokolenia inżynierów i programistów.

First computer to sing – Daisy Bell. https://www.historyofinformation.com/detail.php?id=3986

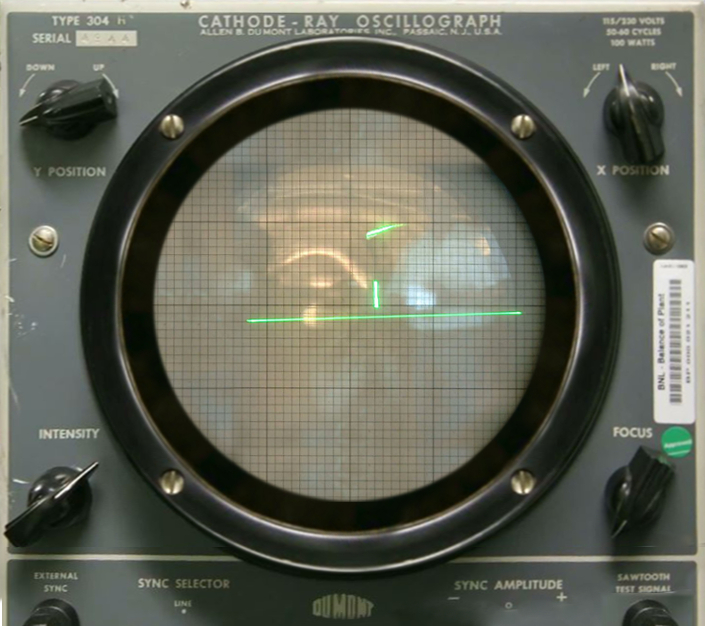

Wkrótce pojawiły się inne „pierwsze razy”. Na przykład, proste melodie zaczęto generować w różnych środowiskach komputerowych, a niektóre z pierwszych grafik rozrywkowych wyświetlano na ekranach. W 1958 roku William Higinbotham stworzył Tennis for Two – prymitywną grę wyświetlaną na oscyloskopie – uznawaną za jedną z pierwszych gier komputerowych. Na początku lat 70., gra Pong wyprodukowana przez Atari rozpoczęła boom na gry wideo, oferując pierwszą komercyjnie udaną rozrywkę komputerową. Tej fali nowych rozwiązań nie dało się już zatrzymać (uwierzcie mi, niektórzy próbowali). Tak oto narodził się świat gier i elektronicznej rozrywki, który szybko zyskał na popularności i różnorodności. Pierwsze automaty do gier zawojowały lokale rozrywkowe, przyciągając tłumy graczy, a konsole domowe umożliwiły wprowadzenie tej zabawy prosto do domów. Gdy komputery 'weszły pod strzechy’, szybko przestały być wyłącznie narzędziami biurowymi. Stały się 'królestwem rozrywki’ – od strategicznych symulacji po „zbereźne” gry, które eksplorowały coraz odważniejsze tematy.

Ten nurt rozwijał się bez końca – gry stawały się coraz bardziej zaawansowane pod względem grywalności, oprawy audio i grafiki, co przyciągało miliony użytkowników na całym świecie. Narodził się gigantyczny przemysł, który nie tylko zyskał na znaczeniu, ale i na wartości. W samej dekadzie lat 80. branża gier zaczęła przynosić miliardy dolarów czystego zysku, wyprzedzając pod tym względem przemysł filmowy i muzyczny. Dziś trudno wyobrazić sobie świat bez gier – od prostych aplikacji mobilnych po rozbudowane światy VR, to przestrzeń bez granic, która wciąż zaskakuje i inspiruje kolejne pokolenia.

Informatyka się dzieli

Informatyka dzieli się na wiele fascynujących działów, które przenikają niemal każdą sferę naszego życia. Od projektowania w inżynierii, przez sztukę cyfrową, multimedia, aż po zarządzanie inteligentnymi miastami – każda z tych dziedzin ma swoje unikalne oprogramowanie i technologie, które kształtują nowoczesny świat. Skupmy się na kilku najciekawszych obszarach i ich przykładach.”

Budownictwo i Inżynieria: Pierwszym przełomem w informatyce inżynierskiej było wprowadzenie programów CAD (Computer-Aided Design), które zrewolucjonizowały sposób projektowania budynków, mostów i innych konstrukcji. Dzięki narzędziom takim jak AutoCAD inżynierowie i architekci mogli tworzyć precyzyjne modele 2D i 3D. Programy te umożliwiły nie tylko szczegółowe projektowanie, ale także symulacje, analizy wytrzymałości i testowanie projektów pod kątem różnych warunków fizycznych. Programy do inżynierii mechanicznej, takie jak SolidWorks czy CATIA, pozwalają na projektowanie skomplikowanych układów mechanicznych, które są testowane zanim powstanie pierwszy fizyczny prototyp.

Rzućcie okiem na blog www.shapr3d.com i artykół: History of CAD oraz The first commercial CAD system

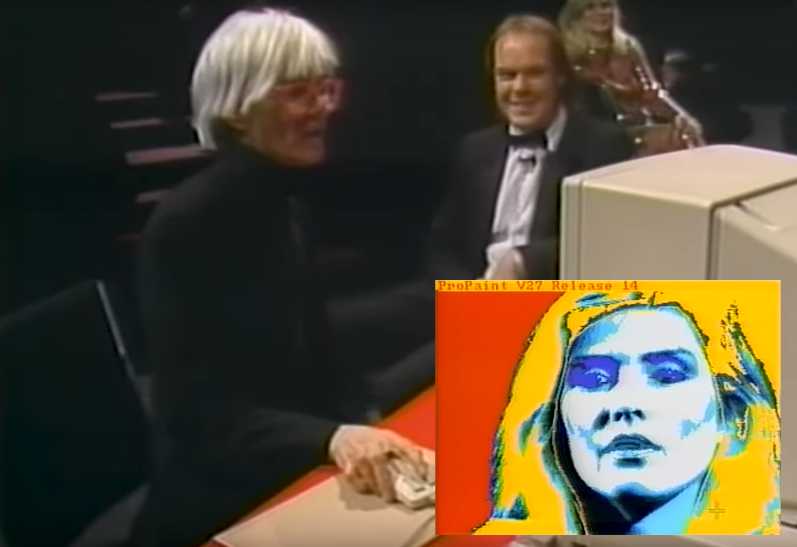

Sztuka i Kreatywność: Sztuka cyfrowa rozwijała się równolegle z rozwojem komputerów. Już w latach 60. zaczęto wyświetlać na ekranie proste obrazy, a wraz z pierwszymi algorytmami fraktalnymi pojawiły się wizualizacje o niespotykanej złożoności. W latach 70. pojawił się program SuperPaint, a Martin Newell stworzył słynny trójwymiarowy model czajnika, który testował algorytmy modelowania 3D. Lata 80. przyniosły Apple MacPaint i Deluxe Paint na Amigę, które pozwalały użytkownikom na bardziej zaawansowane tworzenie grafiki bitmapowej, co stało się popularne w branży gier. Andy Warhol zapisał się w historii, używając Amigi do tworzenia cyfrowych portretów, a wraz z rozwojem programów takich jak Photoshop i Corel Draw, grafika cyfrowa zaczęła dominować w sztuce i designie.

Multimedia i Kompresja Audio-Wideo: Multimedia były kolejnym kamieniem milowym w rozwoju informatyki. Lata 90. przyniosły rewolucję MP3, która zrewolucjonizowała przemysł muzyczny, pozwalając na kompresję plików audio bez dużej utraty jakości. Kompresja wideo również przyniosła ogromne zmiany, umożliwiając streaming i transmisje na żywo, które dzisiaj są normą. Format MPEG pozwolił na redukcję rozmiaru wideo, co z kolei umożliwiło szybsze przesyłanie i przechowywanie dużych plików. W szczególności w sporcie informatyka umożliwiła rewolucję w transmisjach, dzięki grafice telewizyjnej – dane na żywo, takie jak statystyki czy analizy ruchów zawodników, wyświetlane są bezpośrednio na ekranie, dzięki zaawansowanym algorytmom i systemom do przetwarzania obrazu.

Moda: Informatyka znalazła zastosowanie również w modzie. Programy do symulacji komputerowej pozwalają projektantom testować projekty w środowisku wirtualnym, a druk 3D umożliwia tworzenie unikalnych, spersonalizowanych dodatków. Algorytmy zaczynają również analizować trendy i przewidywać przyszłe style, co znacząco wpływa na branżę modową.

Rolnictwo: Na polach uprawnych zaawansowane technologie wspierają precyzyjne rolnictwo. Drony, sensory i systemy komputerowe monitorują stan gleby, wilgotność oraz zdrowie roślin, dostosowując na tej podstawie ilość nawozów i wody. Programy do analizy danych pomagają rolnikom lepiej zarządzać zasobami, co zwiększa plony i zmniejsza koszty.

Medycyna: Informatyka otworzyła zupełnie nowe perspektywy w medycynie, wyznaczając standardy, o których wcześniej można było jedynie marzyć. Sztuczna inteligencja i analiza danych odgrywają kluczową rolę w diagnozowaniu chorób i dobieraniu terapii – algorytmy są w stanie wychwycić wzorce w ogromnych zbiorach danych medycznych, co często prowadzi do szybszych i dokładniejszych diagnoz, a także bardziej spersonalizowanego leczenia. Druk 3D umożliwia natomiast produkcję protez, implantów oraz modeli narządów precyzyjnie dopasowanych do pacjenta, co skraca czas operacji i minimalizuje ryzyko komplikacji.

Nowoczesna medycyna korzysta również z robotyki, gdzie roboty chirurgiczne, jak da Vinci, wspierają lekarzy podczas skomplikowanych operacji, zapewniając większą precyzję i minimalizując ryzyko błędów. Robotyka rozwija się dynamicznie również w rehabilitacji – roboty pomagają pacjentom odzyskać sprawność ruchową po urazach czy operacjach, a także wspierają terapie osób starszych.

Wirtualna rzeczywistość (VR) znalazła swoje miejsce w medycynie jako narzędzie do symulacji i szkolenia. VR umożliwia lekarzom i studentom medycyny przeprowadzanie operacji w środowisku wirtualnym, pozwalając na praktykę bez ryzyka dla pacjentów. Ponadto VR jest stosowane w terapii bólu oraz w leczeniu lęków i zaburzeń psychicznych, tworząc bezpieczną przestrzeń do przepracowania trudnych emocji i doświadczeń.

Innowacyjne rozwiązania obejmują również programowalne kapsułki oraz sondy, które rewolucjonizują diagnostykę i leczenie. Programowalne kapsułki to mikroskopijne urządzenia, które po połknięciu przez pacjenta przemieszczają się przez układ pokarmowy, monitorując stan zdrowia lub dostarczając leki bezpośrednio do chorych tkanek. Podobnie, miniaturowe sondy są w stanie zbierać dane z trudno dostępnych miejsc organizmu lub aplikować leki punktowo, co zwiększa skuteczność leczenia przy minimalnych skutkach ubocznych.

Zarządzanie miastami – Smart Cities: Informatyka pomaga także w zarządzaniu miastami. W inteligentnych miastach systemy komputerowe monitorują ruch uliczny, zarządzają oświetleniem i zużyciem energii, a także monitorują jakość powietrza i poziom hałasu. W Barcelonie czy Singapurze informatyczne rozwiązania pozwalają władzom miejskim na podejmowanie lepszych decyzji, które wpływają na komfort życia mieszkańców.

Sport: W świecie sportu informatyka pozwala na analizę danych w czasie rzeczywistym. Drużyny wykorzystują dane do optymalizacji strategii gry i monitorowania kondycji zawodników. Czujniki rejestrujące ruchy graczy oraz programy analizujące ich zachowanie pomagają w przewidywaniu kontuzji i dostosowywaniu treningów. Wirtualna rzeczywistość umożliwia natomiast sportowcom symulowanie różnych sytuacji, co jest przydatne w przygotowaniach do meczów czy zawodów.

Każda z tych dziedzin informatyki rozwija się dynamicznie, tworząc hybrydy i nowe zastosowania, które jeszcze niedawno były nie do pomyślenia. Informatyka nie tylko ułatwia nam codzienne życie, ale także poszerza granice tego, co możemy osiągnąć w sztuce, medycynie, rolnictwie czy rozrywce.

Rozwój informatyki to opowieść o nieustannym postępie, w którym każdy wynalazek i każde odkrycie budowały fundamenty pod kolejne przełomy. Od mechanicznych maszyn obliczeniowych przez wczesne komputery lampowe i tranzystorowe aż po współczesne technologie oparte na układach scalonych – każdy etap tej historii przesuwał granice ludzkich możliwości, otwierając nowe obszary badań, innowacji i rozrywki.

Informatyka od zawsze była siłą napędową transformacji. Obecnie stała się nieodłączną częścią codziennego życia, rozwijając się w tak różnorodnych dziedzinach, jak medycyna, edukacja, rozrywka, inżynieria, a nawet moda i rolnictwo. To, co kiedyś było nieporównywalnie trudne do wyobrażenia, dziś wydaje się proste, ale wciąż przed nami są wyzwania, których nie sposób jeszcze w pełni pojąć. Cyfrowe narzędzia sprawiły, że nasze życie stało się łatwiejsze, bardziej złożone, ale i bardziej połączone niż kiedykolwiek wcześniej.

Wizja na przyszłość

Patrząc w przyszłość, informatyka stoi u progu nowych odkryć i możliwości. Rozwój komputerów kwantowych, biologicznych i fotonicznych już teraz pozwala przełamywać dotychczasowe ograniczenia, a sztuczna inteligencja rozwija się w szybkim tempie, stając się kluczowym narzędziem analizy, automatyzacji i wsparcia w rozwiązywaniu problemów. Wraz z nimi rośnie znaczenie etycznego podejścia do technologii: przed nami pytania o prywatność, bezpieczeństwo danych i granice ingerencji technologii w ludzkie życie.

W najbliższych latach możemy spodziewać się większej integracji informatyki z rzeczywistością fizyczną. Technologie takie jak rozszerzona rzeczywistość (AR) i wirtualna rzeczywistość (VR) już teraz wpływają na edukację, szkolenia zawodowe i sztukę, ale mają potencjał, by zdefiniować naszą codzienność na nowo. Informatyka może również przekształcić sektor ochrony środowiska, dzięki czemu precyzyjne monitorowanie i zarządzanie zasobami naturalnymi stanie się rzeczywistością, a rozwiązania takie jak inteligentne miasta będą w stanie wspierać zrównoważony rozwój na szeroką skalę.

Krytyczna perspektywa: Komercjalizacja i marketing

Choć przyszłość informatyki niesie wielkie nadzieje, nie sposób pominąć wyzwań, jakie przynosi ze sobą wszechobecna komercjalizacja. Coraz częściej marketing narzuca trend „wartości dodanej” do produktów cyfrowych, co prowadzi do tworzenia aplikacji i rozwiązań opartych na pozornych potrzebach, zamiast faktycznego rozwoju funkcjonalności. W efekcie wiele „okołoprogramistycznych” technologii jest bardziej wydmuszką marketingową niż realnym narzędziem, mającym pozytywny wpływ na użytkowników. Sporo jest też „nakładek” na już istniejące programy (nawet darmowe), które są tworzone bardziej dla zarobku niż dla ułatwienia życia użytkownikom aplikacji pierwotnych.

Przykładem może być afera wokół inkluzywności w gamedevie – gdzie, choć idea jest szlachetna, sposób jej wdrażania bywa zdominowany przez działania PR-owe (to co promowało Sweet Baby Inc mocno odbiło się czkawką wśród graczy), co wywołuje niekiedy nieufność. Odnoszę też wrażenie, że skończył się czas „tworzę grę dla graczy, bo lubię grać, to niech w coś dobrego pograją inni” a zaczął się czas „stworzę grę, by zarobić, a gracze i tak to kupią i jeszcze dopłacą za dodatki do gry, za którą już i tak zapłacili.” dodatkowo tylnymi drzwiami weszło rozwiązanie w którym płacimy tyle samo za produkt (a nawet więcej) i nie są jej właścicielami. To podejście odbiera dawną autentyczność branży gier (i nie tylko), pozostawiając przestrzeń, w której gry stają się bardziej produktem niż dziełem zorientowanym na „fun” czyli zabawę.

Warto zadać pytanie, czy informatyka, skupiona na marketingowych trendach i komercyjnych strategiach, nie ryzykuje utraty swojej innowacyjnej istoty. Przyszłość tej dziedziny, aby uniknąć marazmu, wymaga nie tylko dynamicznego rozwoju, ale i odpowiedzialnych decyzji oraz autentycznego zaangażowania twórców, dla których technologia ma przede wszystkim służyć ludziom, a nie tylko sprzedaży.

Informatyka stała się potężnym narzędziem, kolejne pokolenia informatyków, inżynierów i twórców muszą nieustannie poszukiwać odpowiedzi na wyzwania związane z jej etycznym i odpowiedzialnym wykorzystaniem. Przyszłość tej dziedziny obiecuje postęp w każdej sferze życia, ale jednocześnie wymaga, byśmy przyjęli na siebie odpowiedzialność za świat, który zbudujemy dzięki nowym technologiom.

Powiem, wam że słuchałem kiedyś słyszałem pewna anegdotę a jej inną wersję przeczytałem chyba w „autoexpert.pl „gdyby samochody rozwijały się tak szybko jak komputery, to dziś na jednym tankowaniu można byłoby przejechać dystans z Ziemi na Księżyc i z powrotem w rozsądne kilka godzin.„ słyszałem też (w moich kręgach) stwierdzenie: „gdyby samochody rozwijały się tak jak komputery (informatyka) to dzisiaj jeździły by samodzielnie z prędkością dźwięku produkując darmowy wodór” oczywiście to żart, ale wydaje się trafny.

Planuje jeszcze zebranie materiałów i stworzenie 4 postu o „Historii Informatyki” ale będzie to (jak napisałem na początku) coś w rodzaju wersji 3.5 tego artykułu. Postaram się opowiedzieć więcej o sprzęcie.

Do następnego artykułu

Aleksander Marcin Sanetra